- Open Garden

- Posts

- Publicité digitale : ce qui a cassé l’Open Web... et comment le réparer

Publicité digitale : ce qui a cassé l’Open Web... et comment le réparer

Les chiffres de l’Observatoire de l’epub 2025 sont tombés. La très bonne nouvelle, c’est que 2025 a été un excellent cru pour la publicité digitale en France, avec 12 442 millions d’euros investis.

Cela signifie que le gâteau n’a jamais été aussi gros, que le marché a quasiment fait x4 en 10 ans et qu’il continue de croître de +11% par an !

Cependant, le gâteau n’a jamais été aussi mal partagé :

8 plateformes (majoritairement des walled gardens) captent 76% des investissements et 83% de la croissance.

Les sites “Edition & Info”, qui représentent le coeur de l’Open Web, perdent 8% sur le display et 5% sur la vidéo et ne pèsent dopnc plus que 5% de part de marché sur la publicité digitale.

Pourtant l’Open Web possède des atouts indéniables qui pourraient lui permettre de reconquérir des parts de marché face aux Walled Gardens (cf ci-dessous). Mais pour ça il y a des problèmes à résoudre.

Dans cet article nous essaierons de 1° comprendre ce qui a pénalisé l’Open Web et 2° apporter des propositions concrètes pour le redynamiser

Quels sont le(s) problème(s) de fonds de l’OpenWeb ?

Pour choisir sur quelle régie investir, les annonceurs vont adopter une stratégie ROIste basée sur 3 critères :

La capacité à bien délivrer le message (= le format)

La capacité à toucher l’audience cible (= le ciblage)

La facilité d’activation (= scalabilité / standardisation)

La bonne nouvelle c’est que, concernant la scalabilité, l’Open Web dans son ensemble est assis sur une mine d’or : le top 500 des sites français compte environ 11 milliards de pages vues tous les mois (source Similar Web). Les inventaires sont majoritairement sur le device mobile, le device identitaire des individus avec lequel ils se lèvent le matin et se couchent le soir.

La standardisation est déjà reine sur l’Open Web, avec plus de 80% des investissements qui s’effectuent via l’Open Auction sur le Display (source Baromètre Alliance Digitale)

La mauvaise nouvelle, c’est que concernant les formats et le ciblage, l’Open Web a accumulé un énorme retard face aux walled gardens…

La fatigue des annonceurs face aux dérives de l’Open Web

Il y a un problème de fond avec l’Open Web : les investissements publicitaires sont davantage corrélés à la densité de bid requests envoyées par les sites, plutôt qu’au leur trafic réel des sites.

Certains éditeurs, dont le business model est centré sur la pub (appelons les “éditeurs pub first”), ont donc commencé à adopter des stratégies publicitaires agressives pour augmenter leurs revenus / page vue :

multiplication des bannières publicitaires affichée à l’écran

recours massif aux emplacements sticky ads

augmentation des ad rotations/ ad refreshs

augmentation du nombre de sièges SSP

A force de perdre des parts de marché face à ce genre de pratique, les autres éditeurs se sont retrouvés coincés dans un dilemme du prisonnier. P

our limiter la casse, ils sont nombreux à avoir fait un petit pas dans le même sens : augmentation du nombre d’emplacements publicitaires par page, et du nombre de bidders branchés dans les adservers des éditeurs.

Mais en agissant de la sorte, c’est tout l’Open Web qui prend le risque de :

Détériorer l’expérience utilisateur = risque de baisse du trafic

Détériorer l’expérience de marque = risque de baisse des investissements des annonceurs

Et à la fin, tout le monde sera perdant. Les éditeurs “pub first” tirent leur épingle du jeu à court terme, mais c’est une stratégie risquée à moyen terme. Les éditeurs premiums restent la tête d’affiche du festival mais si un jour ils se trouvent contraints de jeter l’éponge, probable que les annonceurs coupent définitivement le robinet de l’Open Web…

Mais bon après tout : chaque éditeur est libre de faire ce qu’il veut de ses inventaires. C’est plutôt les acteurs du buy-side qui devraient s’inquiéter de ce genre de pratiques qui dégradent l’expérience publicitaire pour les marques.

Malheureusement, ce n’est pas simple pour les acheteurs d’auditer proprement leurs investissements sur l’OpenWeb, puisque rares sont les DSP qui partagent les “placement ID” dans leur interface.

Ca devient difficile de lire les articles sans cliquer par inadvertance sur une publicité sur certains sites de l’Open Web (exemple à peine exagéré)

Des formats standards trop désuets

Si on regarde du côté des walled gardens, voici les formats qui ont réussi à séduire les annonceurs :

Le fullscreen : c’est ce que propose notamment les acteurs de la CTV, mais aussi les réseaux sociaux avec les formats “stories”. Le message passe parfaitement vu que la régie offre 100% de screenshare à la marque sur un temps d’au moins 5s.

Les formats intégrés : C’est que propose les réseaux sociaux (ex : page post) les retailers (sponsored product) les moteurs de recherche (liens sponsorisés).

Et c’est là qu’on constate un gros décalage avec l’Open Web.

Côté Display :

Les investissements sont toujours massivement concentrés sur les bannières IAB classiques (ex : 300x250, 320x50, etc) qui n’ont pas évolué depuis les années 90’. Les taux d’engagement et d’Attention (hors retargeting) sont proches de zéro (CTR qui varie entre 0,03% et 0,25% selon les devices).

Côté Vidéo :

Les formats proposés sur l’OpenWeb ont des qualités : Certains éditeurs ont travaillé le screenshare et l’emplacement sticky, sacrifiant une part d’écran conséquente aux marques. Mais elles ont un défaut de taille. Rares sont les players qui activent le son…

Mettez-vous à la place d’un annonceur : “Vous désirez raconter une histoire, vous avez payé rubis sur ongle votre agence créa pour qu’elle vous produise ce montage vidéo qualitatif de 30s. Seriez-vous content d’apprendre que vous avez investi en publicité pour que votre histoire soit diffusée auprès de votre audience… Sans le son ?! “ Probablement pas.

Impossible de partir à la reconquête des annonceurs avec une proposition de valeur qui accumule autant de retard sur les formats. Un autre point important : lorsque les inventaires sont disponibles en abondance, les acheteurs favorisent massivement l’open auction (80% des investissements sur le Display d’après le baromètre d’Alliance Digitale). Pour s’imposer dans sur le marché de la publicité digitale, l’OpenWeb doit changer complètement ses formats standards.

Des audiences first party très qualitatives mais trop peu fluides

Les éditeurs sont concentrés sur la vente de leurs inventaires et leurs taux de remplissage. Pour eux, les audiences servent avant tout à améliorer la vente de leurs inventaires. Alors que ce sont deux actifs différents, qui pourraient être monétisés distinctement.

Sur les audiences, à date, il y a une incompatibilité structurelle entre ce que veulent les traders et ce que proposent les éditeurs :

Comme évoqué précédemment, lorsque les inventaires sont disponibles en abondance, les acheteurs favorisent l’open auction.

Alors que les éditeurs commercialisent majoritairement leurs first-party data via des deals sur leurs propres inventaires.

En toute logique, sur l’open auction, les traders se tournent donc vers des intermédiaires (les data providers des data marketplaces DSP) qui leur proposent des segments d’audience massifs, exploitables sur la majorité des inventaires, mais qui ont des désavantages :

Opacité sur la constitution des segments d’audience

Quasiment exclusivement basés sur les cookie_IDs (inutilisables sur tous les inventaires cookieless)

frais d’intermédiation (quand ils ne sont pas proposés gratuitement, ex : segments Google)

Repenser la proposition de valeur publicitaire : les formats

Miser sur un standard fullscreen

Les éditeurs ont une solution simple à leur problème de format : vendre des intégrations fullscreen 5 secondes (exemple type : interstitiel mobile).

Plusieurs avantages :

Pour les marques

Très bon taux d’attention et d’engagement grâce aux délais d’attente

L’interstitiel offre aux éditeurs des CPM moyens + attractifs (x5 d’après le baromètre Alliance Digitale comparé aux petites bannières) ce qui compense la baisse du nombre d’emplacements publicitaires par page.

Le fullscreen 5s ouvre un champ des possibles impressionnant sur le volet formats intégrés. Exemple : en couplant fullscreen et native ads, on aurait un bon équilibre entre standardisation et multiplicité des rendus créas possibles.

Fonctionne en mobile, et sur le desktop (ex : interstitiel sur Allociné)

Pour les utilisateurs

Permet d’éviter la fatigue engendrée par les stratégies de monétisation agressives (à condition bien entendu qu'après le fullscreen l’article soit épuré de toute publicité!)

L’éditeur pourrait rendre les formats fullscreen plus sympathique en ajoutant des mentions comme “sponsorisé par” ou « consulter votre article grâce à » (largement popularisées par les Youtubeurs)

Les internautes sont déjà habitués aux publicités fullscreen en CTV et en in-app

Si c’est si simple, pourquoi personne ne le fait ?

A cause de Google qui, il y a plusieurs années, a décidé de rejoindre le programme Coalition for Better Ads et décidé de pénaliser en SEO les sites qui utilisent ce format (au même titre que les popup par exemple).

Ce qui est en soit un non-sens :

Le format interstitiel est massivement utilisé in-app

Google lui-même n’a pas beaucoup de scrupule à pousser du fullscreeen sur Youtube…

Cependant, comme le trafic Google vers les éditeurs va drastiquement diminuer dans les prochains mois à cause des LLM, il est peut-être temps pour les éditeurs de s’affranchir du diktat imposé.

L’expérience publicitaire parfaite pour les marques : le format fullscreen mobile skip 5s

Standardiser et intégrer des formats ambitieux dans le protocole OpenRTB

Dissociées, les bannières IAB génèrent peu d’impact. Mais une fois unifiées et intelligemment disposées sur la page (et donc pas de sticky banners dans tous les sens), elles améliorent l’expérience publicitaire pour les marques et les internautes, et renforce les taux de mémorisation.

En créant un nouveau standard d’exclu page intégré au protocole OpenRTB, les éditeurs pourraient offrir une expérience publicitaire immersive aux marques, et même réadresser les annonceurs du Luxe avec ce format.

Une autre piste intéressante: quand les internautes se rendent sur des sites de presse, c’est pour LIRE du contenu. Pourquoi ne pas jouer la carte de l’intégration format à fonds en proposant des articles sponsorisés (avec un skip 5s par exemple).

Cela permettrait d’apporter un format différenciant dans l’écosystème par rapport aux walled gardens. En théorie, le module “native ads” du protocole OpenRTB pourrait permettre d’intégrer ce genre de format.

La bataille de la vidéo, c’est aussi celle du son

Si les éditeurs de l’Open Web veulent améliorer leurs parts de marché sur la vidéo, ils devraient proposer des formats qui font sens pour les annonceurs. C’est à dire avec un bon screenshare et le son activé, comme par exemple :

De vrais players vidéo “mobile first” (affichage vertical) avec le son activé, un bon screenshare, positionnés au cœur du contenu. Mais pour vendre des prerolls ou des mid rolls, ça sous-entend qu’il faudra produire des contenus vidéos de qualité (ce qui représente un coût non négligeable)

Des interstitiels vidéo skip 5s avec le son activé par défaut. C’est le plus facile à implémenter et ça permettrait de concurrencer les réseaux sociaux et les formats courts de Youtube sur la vidéo.

Repenser la proposition de valeur publicitaire : les audiences

Fluidifier les segments d’audience des éditeurs et des annonceurs

Les éditeurs devraient assumer d’être aussi des first-party data providers. Ils pourraient pousser leurs segments d’audience en toute transparence dans les marketplaces des DSP, avec un fee en pourcentage.

Ex : « audience l’équipe.fr intérêt rugby – 20% fees »

« audience 01net intérêt smartphone samsung – 20% fees »

Les avantages seraient multiples : + de transparence & moins d’intermédiaires = segments plus compétitifs. Les éditeurs pourraient mutualiser les coûts en passant par leurs alliances.

A l’avenir, les campagnes risquent d’être set-uppées/pilotées par des agents IA et/ou des algorithmes de lookalike (ex : initiative Audience Unlimited de TTD qui choisit automatiquement les segments de la marketplace pour faire ses lookalikes). La transparence, la qualité et les coûts compétitifs de ses segments first-party pourraient primer dans le choix des agents IA.

Il y aurait quelques garde-fous à intégrer : notamment le fait de pouvoir bloquer des brands/verticales directement dans les marketplaces DSP. Techniquement les SSP arrivent bien à le faire sur la partie « inventaires publicitaires », donc on devrait facilement pouvoir dupliquer le modèle pour les segments d’audience.

Cerise sur le gâteau : les annonceurs pourraient faire de même. Même s’ils n’ont pas d’inventaire à commercialiser, ils pourraient créer leur régie pour commercialiser leurs first-Party audiences via les sièges Curators (rapide à mettre en place) ou via les data marketplaces (compatible avec l’open auction). L’argent ainsi générés pourrait leur permettre de réinvestir dans leurs propres campagnes digitales. Les agences pourraient vendre de l’accompagnement aux annonceurs sur ce type de projet.

Rendre les segments first-party éditeurs/annonceurs accessibles à tous dans les DSP

Favoriser le login des utilisateurs

Une des grandes forces des GAFAM, c’est que les utilisateurs interagissent avec eux en étant logués. Le Login serait un énorme plus pour les éditeurs : il faciliterait l’interopérabilité des audiences dans un écosystème ouvert comme le programmatique. Imaginez si demain vous pouviez vous appuyer sur toutes les audiences de l’Open Web, mais en CTV par exemple ? Encore un moyen pour les éditeurs de booster la monétisation de leurs audiences.

La raison pour laquelle les éditeurs étaient jusqu’à présent réticents à forcer le login sur leurs sites web, c’est que ça pouvait faire fuir les visiteurs qui arrivent sur le site via les moteurs de recherches ou les liens de redirection. Sauf qu’avec le remplacement progressif des moteurs de recherche par les moteurs de réponse IA, cette partie du trafic va de toute façon drastiquement baisser dans les prochains mois. Certains éditeurs, comme l'Équipe ou le JDN, ont déjà franchi le pas du login wall (sur l’App uniquement pour l’Equipe).

Défendre la valeur des éditeurs

Reconquérir les territoires perdus : le no-consent

La RGPD impose aux éditeurs de récupérer le consentement des internautes afin de pouvoir tracer leur activité en ligne à des fins de revente publicitaire. Lorsqu’on laisse le choix aux internautes, les taux de consentement stagnent à 60% (source Didomi). Et sans identification des individus, c’est beaucoup plus complexe de répondre aux besoins des annonceurs en termes de ciblage / capping / mesure.

La bonne nouvelle pour les éditeurs c’est que la CNIL a assoupli sa position envers les éditeurs, en validant le principe du consent wall. Les éditeurs ont désormais le droit de proposer soit l’acceptation de l’identification sur le site, soit le paiement d’un prix raisonnable. Dans ce cas de figure, rares sont les internautes à payer et les taux de consentement remontent en flèche (>85% d’après Didomi). Des grands éditeurs comme Le Monde, Le Figaro, Les Echos Le Parisien, Webedia, Prisma, Le Bon Coin ont adopté le modèle du 𝘊𝘰𝘯𝘴𝘦𝘯𝘵 𝘞𝘢𝘭𝘭, et pourraient entraîner avec eux le reste du marché.

Les consent walls permettent aux éditeurs de renouer avec des taux de consentement > 85%

2. Reconquérir les territoires perdus : Safari

D’après Statcounter, 27% des Français naviguent sur leur téléphone en utilisant Safari. Et pourtant, d’après Alliance Digitale, Safari ne pèse que 10% des investissements sur l’univers mobile web. Il y a donc un décalage important entre là où se trouvent vraiment les audiences “mobile”, et là où sont concentrés les investissements.

La raison vous la connaissez : Safari fait la guerre aux cookies. Et quoi qu’on en dise, les cookies restent en 2026 la façon la plus simple et économique de faire du ciblage d'audience dans l’écosystème programmatique.

Pourtant, ça fait des années qu’on nous rabâche que c’est possible de faire du ciblage sans cookie, via les identifiants alternatifs notamment (ex : EUID, First-ID, ID5, Pair ID, Panomara ID, RampID, UtiqID,etc.)

Les éditeurs ont plutôt bien joué le jeu d’intégrer des ID sur leurs sites (certains IDs sont présents dans 50% des Bid Requests). Mais le problème de fond, c’est que pour qu’un ID soit vraiment fonctionnel, il faut qu’il soit activable sur toute la chaîne programmatique. C’est à dire :

Sell-Side : Chez l’éditeur & le SSP

External Side : Chez le Data Provider

Buy-side : Dans le DSP (pour la mesure)

Annonceur : Dans les outils d’analytics (pour la mesure)

Si les éditeurs vendaient directement leurs audiences dans les Marketplaces, comme évoqué précédemment, elles seraient compatibles avec tous les IDs déployés par l’éditeur, ce qui renforcerait le ciblage sur Safari.

Remonétiser les inventaires et les audiences Safari

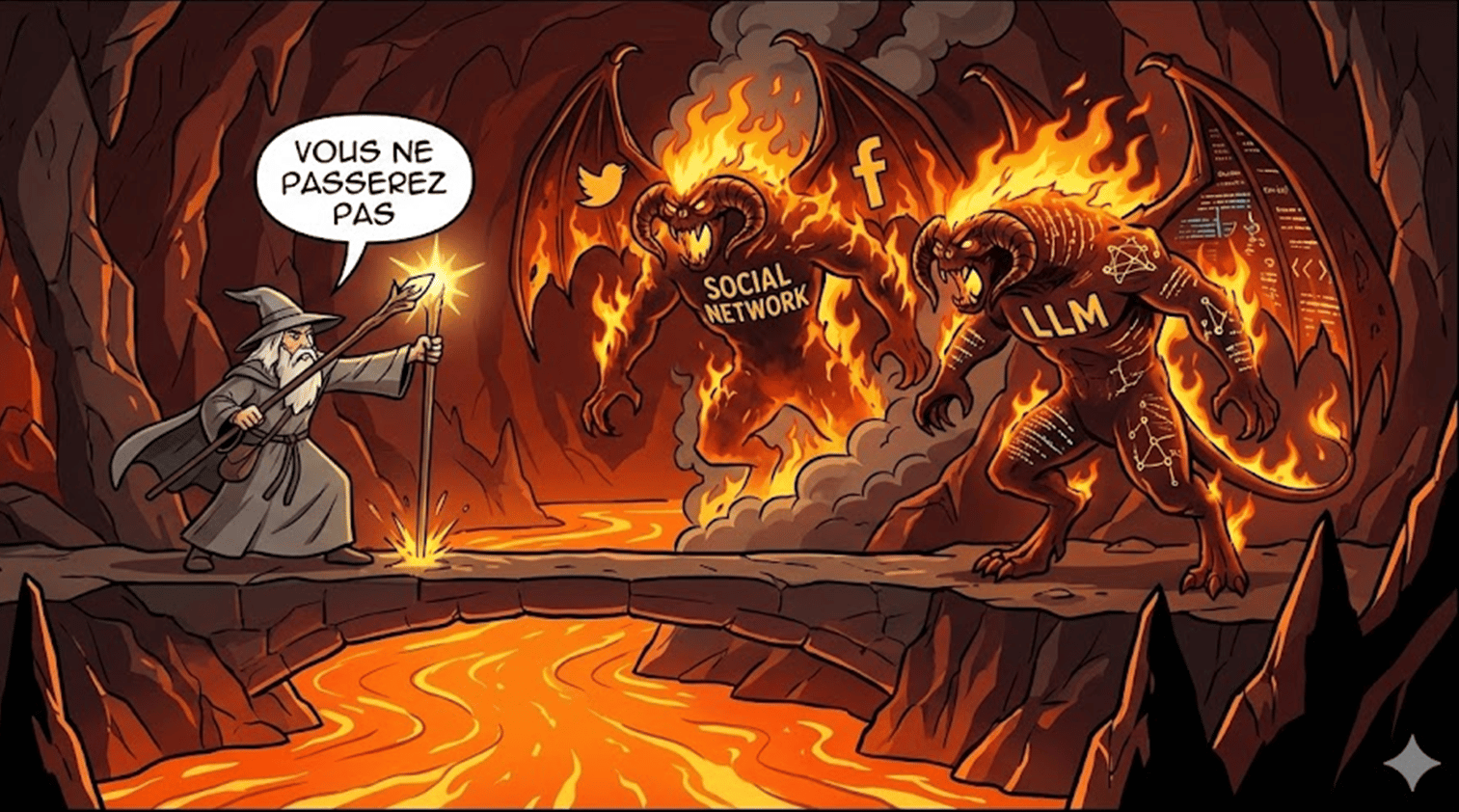

3. Tracer les frontières avec les LLM

Les LLM ont démarré une révolution technologique, et aujourd’hui ChatGPT.com est le 5e site le plus visité de France. Les éditeurs sont déchirés entre deux choix radicalement opposés

laisser les robots scrapper leurs contenus pour espérer récupérer du trafic via les liens sources des LLM ou pour vendre des offres “paid GEO”

bloquer les robots des IA pour protéger leurs contenus

De notre point de vue, les IA ne sont pas les amies des éditeurs : elles enrichissent leurs modèles avec les contenus des sites sans compensation financière, et elles menacent de tarir drastiquement tout le trafic en provenance de la recherche. Aux USA, le déploiement d’AI Overviews a engendré une baisse de 35% du trafic chez les éditeurs.

Les éditeurs devraient tracer une frontière avec les IA : l’entrée est payante ! Et la qualité ça se paie !

Puis se concentrer à augmenter leur trafic “direct”, car ce sont les audiences récurrentes qui sont les plus intéressantes à monétiser.

Pour rappel, la France fait partie des derniers pays où Google n’a pas encore déployé AI Overviews. Pourquoi? Grâce au bouclier juridique des droits voisins, où Google s’exposerait à des compensations financières fortes en déployant ce service. Les éditeurs français ont donc un atout dans leur manche.

4. Limiter le social publishing

Pour compenser, les baisses de revenu, de plus en plus d'éditeurs misent sur le social publishing (posts sponsorisés, stories relayées via leurs comptes Meta, YouTube, X, TikTok).

Le Social Publishing apporte son lot d'avantages pour les éditeurs : ils peuvent augmenter leur reach, et le social publishing améliore les performances media, grâce aux formats intégrés des réseaux sociaux et à l'effet de "caution" médiatique.

Mais il y a quand même un risque non négligeable : que se passera-t-il le jour où les Walled Gardens décideront de déprioriser les contenus des profils pro ? C'est déjà arrivé en janvier 2018 : à l'époque Meta avait modifié son algorithme de recommandation pour donner davantage de visibilité aux individus, occasionnant des baisses de trafic sur les pages entreprises d'en moyenne -28%, avec des chutes pouvant aller jusqu'à -70% sur certaines pages (source Marketing Charts)

Le Social Publishing devrait être envisagé comme une stratégie de conquête, pour s’ouvrir à des audiences plus jeunes, qui surconsomment ce genre d’app, mais l’éditeur devrait toujours garder comme objectif de ramener le lecteur chez lui, sur ses sites ou ses app.

Et pourquoi pas sur les sites des éditeurs rendre l’expérience plus communautaire en ajoutant des sections de commentaires ?

Tracer des frontières claires avec les crawlers des LLM et les réseaux sociaux

5. Limiter le Reselling

Tous les resellers ne se valent pas. Certains apportent une vraie valeur ajoutée, comme un format ou une demande exclusive par exemple. Mais dans la majorité des cas, les resellers sont appelés sur les mêmes impressions que les SSP des éditeurs en direct en prenant une commission au passage.

Les éditeurs pourraient :

Limiter le nombre de Resellers dans leurs stacks, en organisant des compétitions

Revoir l’orchestration de leur stack Header Bidding, en gardant par exemple l’exclusivité sur les bid requests premium (IP France & cookie ID & bonne visibilité & horaire jour), pour brancher les Resellers uniquement là où les taux de remplissage sont plus faibles

6. Qu’est-ce qu’on fait des outils Google ?

Google, c’est un partenaire un peu spécial pour les éditeurs. D’un côté, il faut reconnaître qu’il permet aux éditeurs de monétiser leurs inventaires auprès du SMB. Sans lui, une bonne partie des investissements sur Google Ads du SMB termineraient probablement sur Meta (facilité d’accès). Mais d’un autre côté, les éditeurs ont de très nombreux griefs envers Google (on ne vous refait pas toute la liste).

Un point qu’on sous-estime beaucoup, c’est qu’en branchant les outils publicitaires de Google chez eux, les éditeurs donnent un accès libre à Google à toutes leurs audiences. Vous pouvez faire le test facilement et gratuitement sur les inventaires inapp des éditeurs via l’outil PCSA de l’application Android DuckDuckGo. Installez le et baladez vous sur vos App françaises préférées, et vous verrez que Google est très souvent branché et en profite pour récupérer beaucoup d'informations sur les utilisateurs. Pratique pour alimenter ses propres segments d’audience.

Certes les audiences de Google sont aussi alimentées par d’autres sources (Search, Youtube, toutes les App Google, etc.) mais il faut bien avouer que ça devient compliqué pour les éditeurs de monétiser leurs audiences, si en parallèle ils les offrent sur un plateau d’argent à Google, qui:

les offre gratuitement aux media traders

les utilise pour enrichir son offre de ciblage sur son propre inventaire (Youtube)

Certains éditeurs, notamment BVOD & SVOD, ont fait le choix de passer par des adservers/SSP plus spécialisés, qui ne jouent pas sur plusieurs tableaux à la fois. Si les éditeurs décident de créer un nouvel OpenWeb à forte proposition de valeur, la question de la souveraineté, et donc du choix des outils, devrait être un point central dans les discussions.

Innover

1. Réadapter l’idée du bid caching

Le principe du bid caching est simple : le SSP garde la dernière bid response qu’il a reçue d’un DSP en cache sur un laps de temps défini, le temps de trouver une Bid Request similaire pour servir l’impression.

A l’époque cette pratique avait été fortement critiquée car :

Elle avait été mise en place de façon opaque

Le SSP ne connaissait pas le targeting exact paramétré par l’acheteur dans son DSP. Il ne pouvait pas savoir quelles dimensions la Bid Requests devait obligatoirement contenir du point de vue de l’acheteur (ex : Site ? URL ? Cookie ID ? ID5 ? Heure ? Capping ?)

Pourtant, le concept du bid caching est plutôt astucieux. La publicité programmatique pollue et coûte cher en frais d’infra au SSP & DSP, qui compensent en mettant du throttling.

Le bid caching pourrait permettre de réduire significativement le nombre d’appel entre SSP & DSP, et donc d’amortir intelligemment les coûts d’infra. Mais aussi de booster les SSP des éditeurs si on leur réserve l’exclusivité de la pratique.

Mais cela nécessite de modifier le protocole OpenRTB pour enrichir les bid responses de nouvelles dimensions comme :

Est-ce que j’accepte le bid caching?

Et si oui, quels sont les éléments de targeting à obligatoirement respecter

La durée maximale du caching

Plutôt que de multiplier les bid requests dans tous les sens, pourquoi ne pas intégrer du bid caching côté SSP?

Commencer à préparer le terrain pour valoriser le ciblage “humain”

Le trafic généré par les robots, c’est l’éléphant dans la pièce de l’adtech. Les entreprises de cybersécurité (ex : imperva) alertent sur le fait qu’il y a 50% du trafic internet qui provient des robots. Avec l’explosion des usages IA, la part du trafic robot va augmenter en flèche dans les prochains mois.

Dans l’adtech, le discours est plutôt rassurant, des contrôles stricts étant effectués par les SSP/DSP. Pourtant l’an dernier un reportage a beaucoup fait parlé aux USA : Unclickable (de Babis Makridis). Une journaliste, qui en avait ras-le-bol de se faire voler ses articles par des fraudeurs, a décidé de monter une équipe d’experts pour savoir si c’était simple ou compliqué de se lancer dans l’Adfraude. Spoiler alert, ils ont réussi à détourner pas mal d’argent pendant la durée de leur expérience…

Si les robots ne sont pas clairement identifiés, cela risque de devenir un vrai casse-tête pour les annonceurs de réussir à maximiser leurs investissements sur des vrais clients potentiels humains.

Préparez-vous, le “human-attention” sera le KPI buzzword de 2027 ;-)

Les éditeurs ont une carte à jouer en termes de qualité en rendant les contrôles beaucoup plus poussés, pour garantir aux annonceurs que c’est chez eux qu’ils auront le plus d’opportunité d’améliorer leur “human-attention”. D’ailleurs certains walled gardens, comme Linkedin, déploient déjà une stratégie en ce sens (contrôle de la carte d’identité).

Sans aller jusque-là, les éditeurs pourraient plutôt s’inspirer de leboncoin.fr qui impose déjà des contrôles minimums aux nouveaux utilisateurs (pour limiter le risque de fraude sur les annonces).

Aller plus loin que le TID

Le TID (Transaction ID) est un élément intéressant pour lutter contre le bid repeating. Toutes les bid requests dupliquées ayant un ID commun, ça facilite le travail de SPO pour les DSP. Mais il ne permet pas de lutter contre la deuxième dérive des stratégies publicitaires agressives : la multiplication des emplacements publicitaires par page (ad cluttering).

Un moyen pour lutter contre ce phénomène serait, en plus du TID, d’ajouter un identifiant unique temporaire de la page chargée. Cela permettrait aux DSP de calculer très facilement les niveaux d’ad cluttering de chaque site, pour juger de la qualité de l’opportunité proposée.

Et pourquoi pas un Spotify de la presse ?

C’est notre dernier point, et c’est le plus ambitieux / complexe / stratégique.

Le constat est le suivant :

Vous faites peut-être partie de ceux qui paient un abonnement Spotify, Deezer, Apple Musique,etc. pour écouter vos musiques préférées. Si c’est le cas, seriez-vous prêt à payer un abonnement par maison de disque ? Ça vous paraît absurde, non ?

Et pourtant… C’est ce qui se passe dans la presse. Si vous souhaitez lire sans restriction les articles du Monde, du Figaro, du Parisien, des Echos, de l’Equipe, vous allez devoir passer à la caisse sur chaque app. A l’heure où les individus sont habitués en audio et en vidéo à accéder à des catalogues géants pour 10-15€/mois, ce morcellement dénote fortement.

Du coup, la question paraît légitime, pourquoi pas un Spotify de la presse ?

Avec des formules de prix à la Netflix (ex : 6€ avec un tout petit peu de pub ou 15€ sans pub)

Il y a plusieurs avantages majeurs à adopter une app commune :

Imaginez une app où n’importe qui ne peut pas écrire n’importe quoi = Seuls les articles écrits par les journalistes pourraient être publiés. Dans un futur proche qui s’annonce très “robots & fake news friendly”, cette proposition de valeur deviendrait très pertinente pour les utilisateurs et pour les marques.

Créer une App “réflexe”, seule une poignée des applications installées sur les smartphones sont utilisées quotidiennement par les utilisateurs. Une mega app de contenu a plus de chance d'émerger auprès du grand public, et de créer des synergies entre les créateurs de contenus, que si chacun fait son app dans son coin.

L’App est un écosystème, et on fait a peu prêt ce qu’on veut dans son écosystème (ex : GPT qui permet maintenant aux développeurs externes de créer des mini App dans GPT, WeChat qui est un super app tout en 1 en Chine, etc.)

On peut faire du preloading d’articles et de publicité, ce qui permet de maintenir le lien avec les utilisateurs quand ils sont hors connexion. Pratique pour les trajets en métro ou en train.

On mutualise les coûts. Beaucoup moins de dépendance à Google discovery. Plus facile de récupérer les logins sur une seule app. Comme il s’agirait d’une nouvelle app, les éditeurs actionnaires seraient entièrement libres du choix des techno à utiliser. Ça pourrait être le bon moment pour éviter de brancher les technologies qui alimentent directement les bases de données des concurrents Walled Gardens.

Les éditeurs pourraient utiliser leurs invendus pour faire la promo de cette super App. Il y aura sûrement un sujet avec l’autorité de la concurrence, mais le contexte défavorable aux éditeurs de presse pourrait jouer en leur faveur.

Certes, il y a déjà eu des initiatives d’app commune comme Cafeyn, mais elles proposent surtout des PDF, pas tous les articles onsite, pas de version gratuite avec publicité, et ne bénéficient pas d’auto-promo de la part des éditeurs.

Imaginez une app unique avec tous les articles de vos sites préférés

Conclusion :

Nous arrivons à la fin de notre exercice de propositions. Elles ne sont peut-être pas parfaites, il y aura probablement des débats autour de la faisabilité technique ou politique de certaines. Mais elles ont au moins le mérite d'être là, sur la table.

Comme le montrent les chiffres du SRI et d’Alliance Digitale, l’Open Web français est dans une situation difficile, mais il n’est pas condamné (et nos emplois par la même occasion).

La bonne nouvelle, c’est que malgré les baisses de trafic, il a encore un potentiel indéniable : les milliards de pages vues disponibles tous les mois qui sont connectées aux tuyaux programmatiques.

Les annonceurs sont avant tout des investisseurs avisés. Par pragmatisme ils préféreront miser sur un projet ambitieux avec une vision de potentiel de gain, que sur une option visant à “limiter la casse”. D’où l’immense enjeu de recréer un nouvel Open Web français survitaminé en s’inspirant de ce qui a marché chez nos confrères régies des walled gardens !

Comme l'industrie musicale l’a fait à son époque après 7 ans de décroissance (dû au streaming/piratage), l’heure est aux choix audacieux pour réinventer l’Open Web, et les propositions de valeur évoquées vont dans ce sens :

Repenser les formats standards, fluidifier les segments first-party éditeurs/annonceurs, reconquérir des territoires oubliés, se protéger des LLM et des walled gardens, innover, application commune, etc. Les leviers existent, les chantiers sont nombreux.

Mais aucun ne sera réellement efficace s’ils sont actionnés en ordre dispersé. Les éditeurs français qui ne souhaitent pas s’engager dans des stratégies de monétisation agressives devraient collectivement standardiser les formats immersifs et fluidifier l’activation de leurs audiences.

L’Open Web français peut redevenir un acteur majeur de la publicité digitale française d’ici 2030, à condition de mettre en route les chantiers dès 2026. Il n’appartient qu’à nous, acteurs de l’Open Web français de redresser la barre pour aller chercher collectivement ces milliers de millions ;-)

Propositions pour un nouvel Open Web